Адаптивная ДАП

В версиях ДАП, рассматриваемых до сих пор, весовая матрица вычисляется в виде суммы произведений пар векторов. Такие вычисления полезны, поскольку они демонстрируют функции, которые может выполнять ДАП. Однако это определенно не тот способ, посредством которого производится определение весов нейронов мозга.

Адаптивная ДАП изменяет свои веса в процессе функционирования. Это означает, что подача на вход сети обучающего набора входных векторов заставляет ее изменять энергетическое состояние до получения резонанса. Постепенно кратковременная память превращается в долговременную память, настраивая сеть в ходе ее функционирования. В процессе обучения векторы подаются на слой

Так как доказано, что непрерывная ДАП является стабильной независимо от значения весов, ожидается, что медленное изменение ее весов не должно нарушить этой стабильности.

Простейший обучающий алгоритм использует правило Хэбба, в котором изменение веса пропорционально уровню активации его нейрона- источника и уровню активации нейрона-приемника. В символьной записи это выглядит следующим образом:

где

Емкость памяти

Как и сети Хопфилда, ДАП имеет ограничения на максимальное количество ассоциаций, которые она может точно воспроизвести. Если этот лимит превышен, сеть может выработать неверный выходной сигнал, воспроизводя ассоциации, которым не обучена.

Б. Коско получил оценки, в соответствии с которыми количество запомненных ассоциаций не может превышать количества нейронов в меньшем слое. Для этого емкость памяти должна быть максимизирована посредством специального кодирования, при котором количество компонент со значениями

Известно, что ДАП может иметь до

где

С помощью выбора соответствующего порога для каждого нейрона, количество стабильных состояний может быть сделано любым в диапазоне от 1 до

Например, если

Ограничение количества единиц во входных векторах представляет серьезную проблему, тем более, что теория, которая позволяет перекодировать произвольный набор векторов в такой "разреженный" набор, отсутствует. Возможно, однако, что еще более серьезной является проблема некорректной сходимости. Суть этой проблемы заключается в том, что сеть может не производить точных ассоциаций вследствие природы поля притяжения; об ее форме известно очень немногое. Это означает, что ДАП не является ассоциатором по отношению к ближайшему соседнему образу. В действительности она может производить ассоциации, имеющие слабое отношение ко входному вектору. Как и в случае гомогенных ДАП, могут встречаться ложные стабильные состояния, а об их количестве и природе известно крайне мало.

Несмотря на эти проблемы, ДАП остается объектом интенсивных исследований. Основная привлекательность ДАП заключается в ее простоте. Кроме того, она может быть реализована в виде СБИС (либо аналоговых, либо цифровых), что делает ее потенциально недорогой. Так как наши знания постоянно растут, ограничения ДАП могут быть сняты. В этом случае как в экспериментальных, так и в практических приложениях ДАП будет являться весьма перспективным и полезным классом искусственных нейронных сетей.

Кодировка ассоциаций

Обычно сеть обучается распознаванию множества образов. Обучение производится с использованием обучающего набора, состоящего из пар векторов

Предположим, что все запомненные образы представляют собой двоичные векторы. Это ограничение будет выглядеть менее строгим, если вспомнить, что все содержимое Библиотеки Университета может быть закодировано в один очень длинный двоичный вектор. Показано, что более высокая производительность достигается при использовании биполярных векторов. При этом векторная компонента, большая чем 0, становится

Предположим, что требуется обучить сеть с целью запоминания трех пар двоичных векторов, причем векторы

| Исходный вектор | Ассоциированный вектор | Бинарная версия | |

|  |  |  |

|  |  |  |

|  |  |  |

Вычисляем весовую матрицу:

Далее, прикладывая входной вектор

Используя пороговое правило,

вычисляем

что является требуемой ассоциацией. Затем, подавая вектор

через обратную связь на вход первого слоя к

что дает значение

Этот пример показывает, как входной вектор

с использованием матрицы

ДАП обладает способностью к обобщению. Например, если незавершенный или частично искаженный вектор подается в качестве

Системы с обратной связью могут иметь тенденцию к колебаниям; это означает, что они могут переходить от состояния к состоянию, никогда не достигая стабильности. Доказано, что все ДАП безусловно стабильны при любых значениях весов сети. Это важное свойство возникает из отношения транспонирования между двумя весовыми матрицами и означает, что любой набор ассоциаций может быть использован без риска возникновения нестабильности.

Существует взаимосвязь между ДАП и рассмотренными на предыдущих лекциях сетями Хопфилда. Если весовая матрица

является квадратной и симметричной, то

Конкурирующая ДАП

Во многих конкурирующих нейронных системах наблюдаются некоторые виды конкуренции между нейронами. В нейронах, обрабатывающих сигналы от сетчатки, латеральное торможение приводит к увеличению выхода наиболее высокоактивных нейронов за счет соседних. Такие системы увеличивают контрастность, поднимая уровень активности нейронов, подсоединенных к яркой области сетчатки, и в то же время еще более ослабляя выходы нейронов, подсоединенных к темным областям. В ДАП конкуренция реализуется с помощью взаимного соединения нейронов внутри каждого слоя посредством дополнительных связей. Веса этих связей формируют другую весовую матрицу с положительными значениями элементов главной диагонали и отрицательными значениями остальных элементов. Теорема Кохонена-Гроссберга показывает, что такая сеть является безусловно стабильной, если весовые матрицы симметричны. На практике сети обычно стабильны даже в случае отсутствия симметрии весовых матриц. Однако неизвестно, какие особенности весовых матриц могут привести к неустойчивости функционирования сети.

Непрерывная ДАП

В предшествующем обсуждении нейроны в слоях 1 и 2 рассматривались как синхронные; каждый нейрон обладает памятью, причем все нейроны изменяют состояния одновременно под воздействием импульса от центральных часов. В асинхронной системе любой нейрон свободен изменять состояние в любое время, когда его вход предписывает это сделать.

Кроме того, при определении функции активации нейрона использовался простой порог, образуя разрывность передаточной функции нейронов. Как синхронность функционирования, так и разрывность функций являются биологически неправдоподобными и совсем необязательными; непрерывные асинхронные ДАП отвергают синхронность и разрывность, но функционируют в основном аналогично дискретным версиям. Может показаться, что такие системы должны быть нестабильными. Показано, что непрерывные ДАП являются стабильными (однако для них справедливы ограничения емкости, указанные ранее). С. Гроссберг показал, что сигмоида является оптимальной функцией активации благодаря ее способности усиливать низкоуровневые сигналы и в то же время сжимать динамический диапазон нейронов. Непрерывная ДАП может иметь сигмоидальную функцию с величиной

Структура ДАП

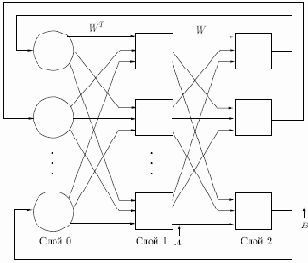

На рис. 10.1 приведена базовая конфигурация ДАП. Она выбрана таким образом, чтобы подчеркнуть сходство с сетями Хопфилда и предусмотреть увеличения количества слоев. На рис. 10.1 входной вектор

или в векторной форме:

где

Рис. 10.1.

Аналогично,

где

Как отмечено нами ранее, Гроссберг показал преимущества использования сигмоидальной (логистической) функции активации

где

— взвешенная сумма входных сигналов нейрона

В простейших версиях ДАП значение константы

выбирается большим, в результате чего функция активации приближается к простой пороговой функции. В дальнейшем будем предполагать, что используется пороговая функция активации.

Примем также, что существует память внутри каждого нейрона в слоях 1 и 2 и что выходные сигналы нейронов изменяются одновременно с каждым тактом синхронизации, оставаясь постоянными в паузах между этими тактами. Таким образом, поведение нейронов может быть описано следующими правилами:

где

в момент времени

Заметим, что, как и в описанных ранее сетях, слой 0 не производит вычислений и не имеет памяти; он является только средством распределения выходных сигналов слоя 2 к элементам матрицы

Восстановление запомненных ассоциаций

Долговременная память (или ассоциации) реализуется в весовых массивах

Сеть функционирует в направлении минимизации функции энергии Ляпунова в основном таким же образом, как и сети Хопфилда в процессе сходимости. Следовательно, каждый цикл модифицирует систему в направлении энергетического минимума, расположение которого определяется значениями весов.

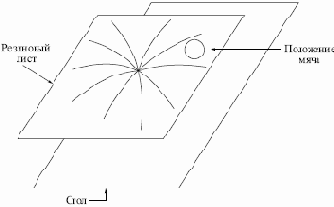

Этот процесс может быть визуально представлен в форме направленного движения мяча по резиновой ленте, вытянутой над столом, причем каждому запомненному образу соответствует точка, "вдавленная" в направлении поверхности стола. Рис. 10.2 иллюстрирует данную аналогию, на нем отмечен один запомненный образ. Данный процесс формирует минимум гравитационной энергии в каждой точке, соответствующей запомненному образу, с соответствующим искривлением поля притяжения в направлении к данной точке. Свободно движущийся мяч попадает в поле притяжения и в результате будет двигаться в направлении энергетического минимума, где и остановится.

Рис. 10.2.